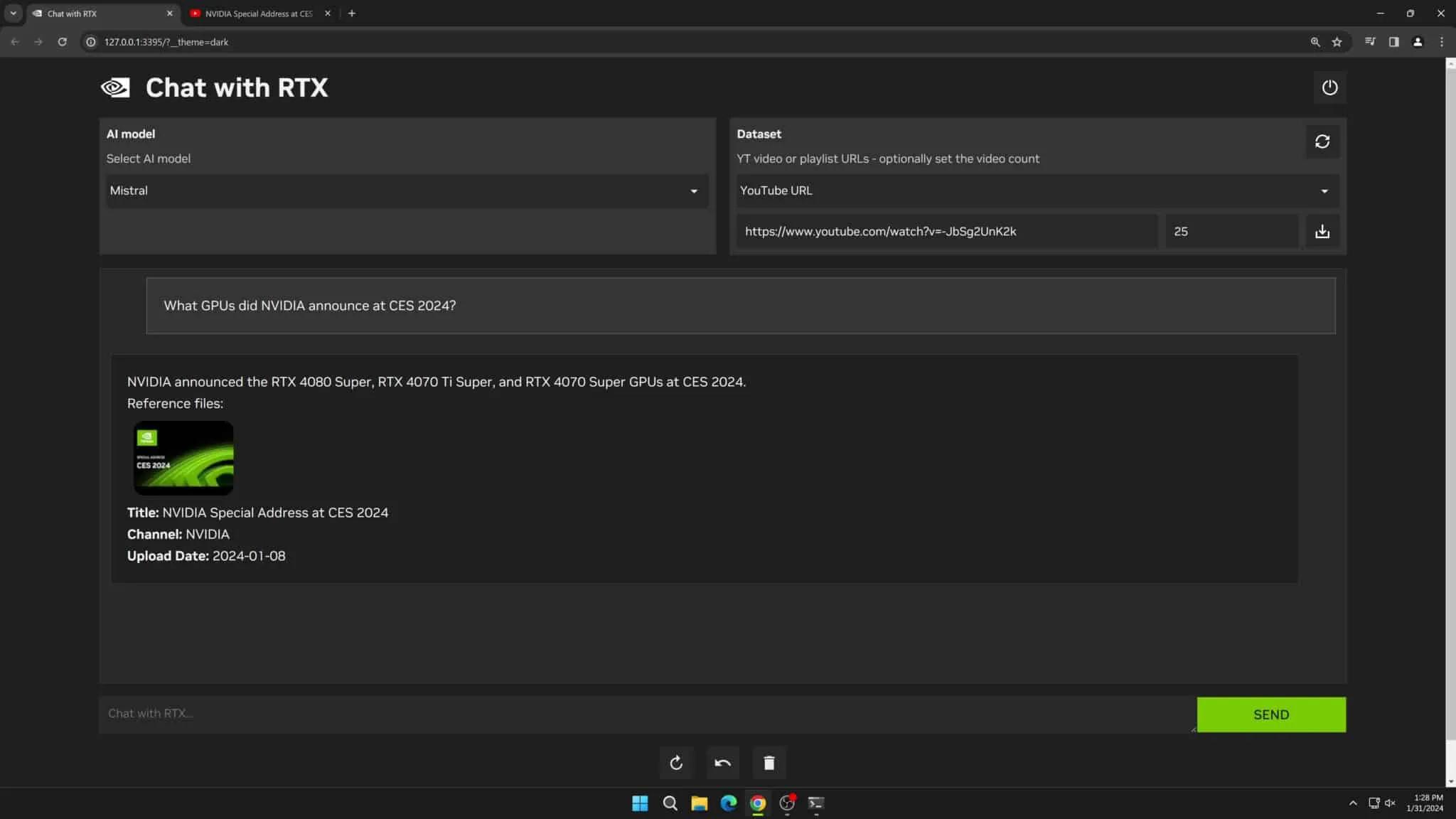

Image: Nvidia

米GPUメーカーのNvidiaは2月13日(現地時間)、Windows PCのローカル上で動作する対話型AI、「Chat with RTX」のテックデモを発表しました。

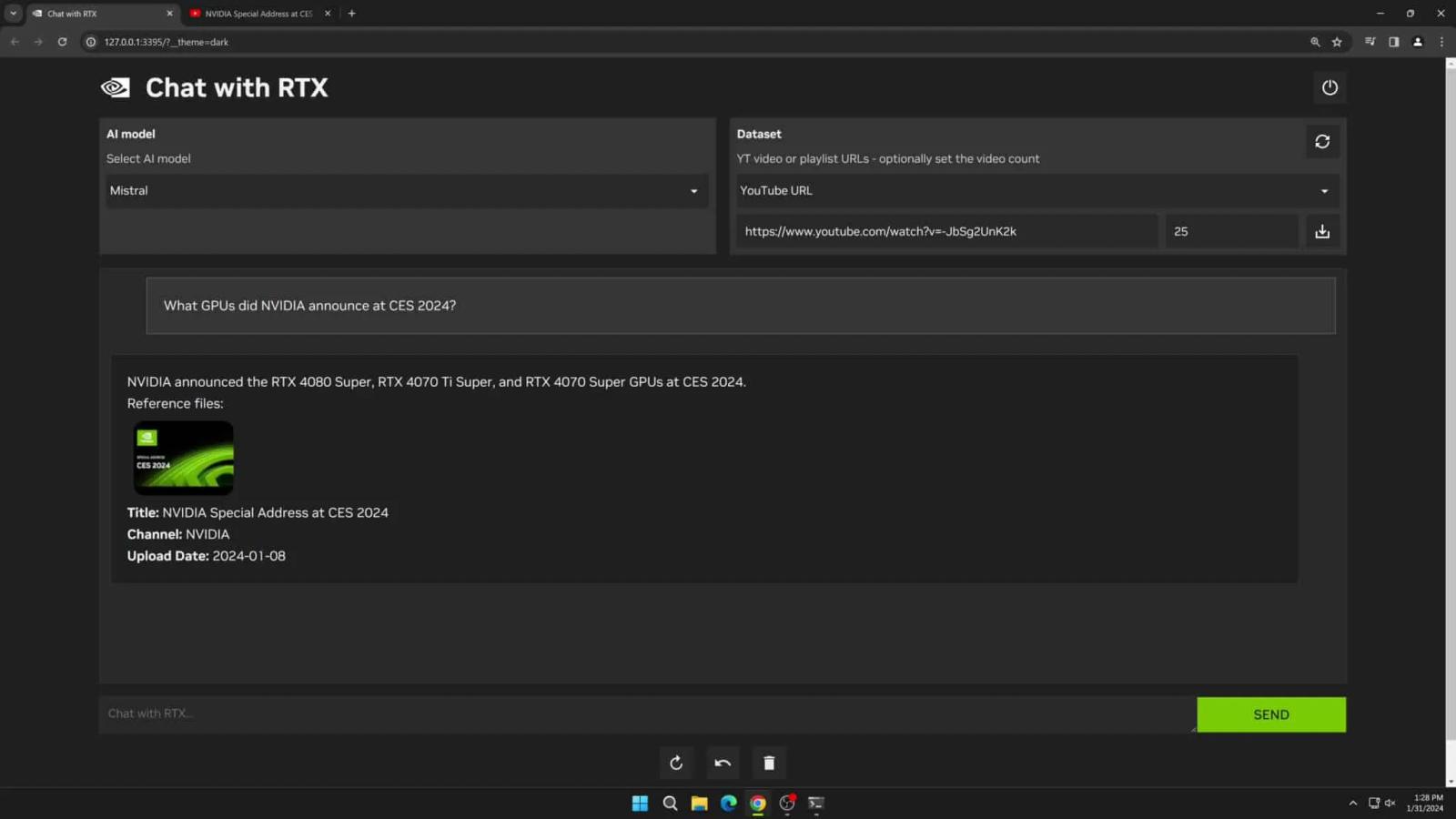

直接PCにインストールして使用する「Chat with RTX」は、オープンソースの大規模言語モデル(Mistral、Llama 2など)に接続し、高速かつ自然な回答が可能とのことで、ローカル上にあるテキストファイル(.txt、.pdf、.doc/.docx、.xml)をスキャンし、その内容に対する回答を得ることも可能。また、YouTube動画やプレイリストから情報を抽出することもできるようです。

他の対話型AIとの違いは?

ChatGPTやGoogle GeminiとChat with RTXの違いは、クラウド上で処理されるか否かです。前者はオンライン上で処理されるサービスであるため、使用するためにはインターネットが必要ですが、後者はローカル上に大規模言語モデル(LLM)などを含めた状態でインストールされるため、全ての処理はオフラインで完結します。

第三者に共有されずに処理されるので、個人情報を入力する際は安心感がありますね。

Chat with RTXは、Windows10/11のOSと、NVIDIA GeForce RTX 30シリーズGPU(VRAM 8GB)以上と最新ドライバーで利用可能とのこと。公式ページよりダウンロードできます。

Source: Nvidia